Bắt tay vào việc nhanh chóng, nói lời tạm biệt với sự phức tạp

Ưu điểm chính của ServBay là cài đặt LLM chỉ bằng một cú nhấp chuột, hoạt động tại chỗ, quyền riêng tư dữ liệu, khả năng sử dụng ngoại tuyến, chi phí thấp hơn. So với dịch vụ LLM đám mây, ServBay không yêu cầu kết nối mạng, dữ liệu được giữ lại tại địa phương, không cần lo lắng về rò rỉ quyền riêng tư.

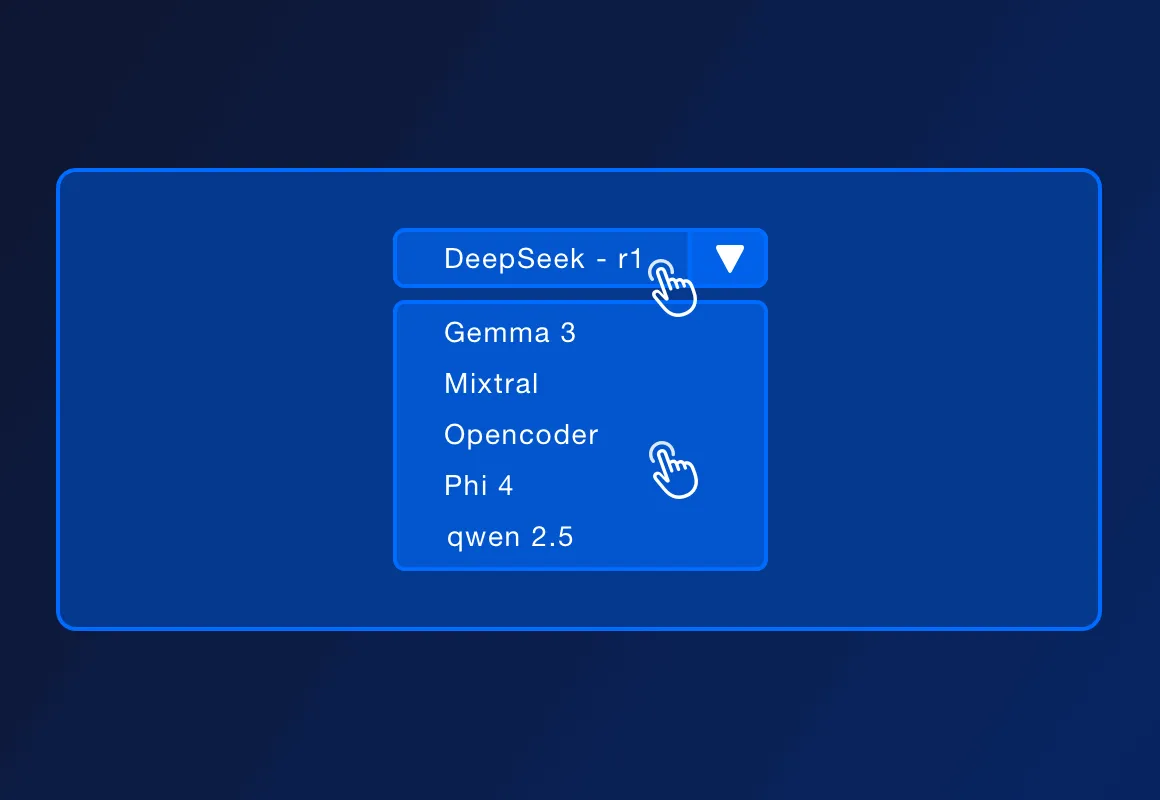

ServBay hỗ trợ nhiều LLM mã nguồn mở phổ biến, chẳng hạn như DeepSeek - r1, Llama 3.3, Mistral, Code Llama, v.v. Danh sách các mô hình hỗ trợ cụ thể có thể tăng lên theo sự cập nhật của chính thức.

ServBay hỗ trợ triển khai các môi trường phát triển cục bộ bằng PHP, Python, Node.js, Go, cùng với Ollama, phù hợp cho phát triển cục bộ, thiết kế nguyên mẫu, học tập và sử dụng cá nhân. Trong các môi trường sản xuất cần cao sự đồng thời, tính khả dụng cao và chức năng quản lý phức tạp, ServBay cũng có thể cung cấp các kế hoạch triển khai chuyên nghiệp hơn.

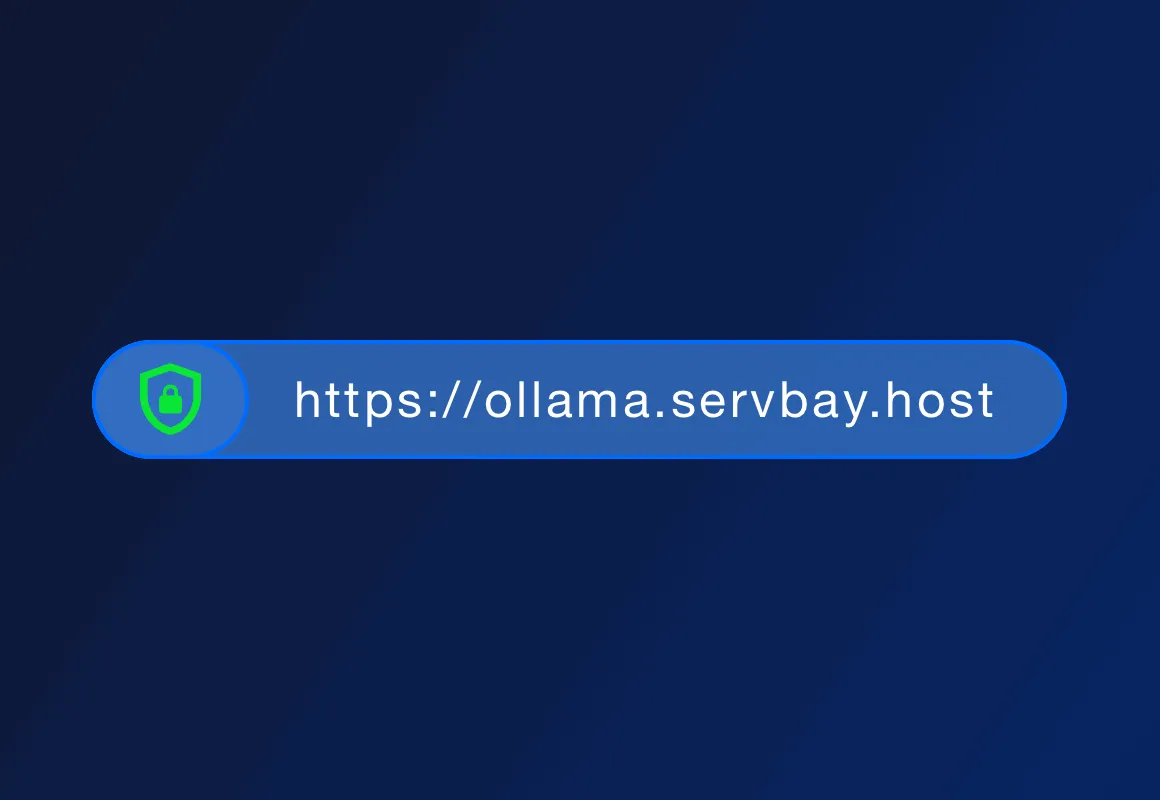

ServBay bản thân là nền tảng quản lý môi trường phát triển, cung cấp triển khai môi trường phát triển cho các ngôn ngữ như PHP, Python, Node.js và Go, đồng thời còn cung cấp hỗ trợ cho các cơ sở dữ liệu và máy chủ khác nhau. Hiện tại, ServBay còn hỗ trợ cài đặt Ollama chỉ bằng một cú nhấp chuột, các nhà phát triển có thể tương tác với các mô hình chạy cục bộ thông qua REST API được cung cấp bởi Ollama, gửi đầu vào văn bản và nhận đầu ra từ mô hình, từ đó có thể xây dựng các ứng dụng và dịch vụ AI ứng dụng khác nhau tại chỗ.