Aprendizado rápido, adeus à complexidade

As principais vantagens da ServBay incluem instalação com um clique do LLM, operação local, privacidade de dados, disponibilidade offline e custos mais baixos. Comparado aos serviços LLM em nuvem, a ServBay não requer conexão de rede, os dados são mantidos localmente, eliminando preocupações com vazamento de privacidade.

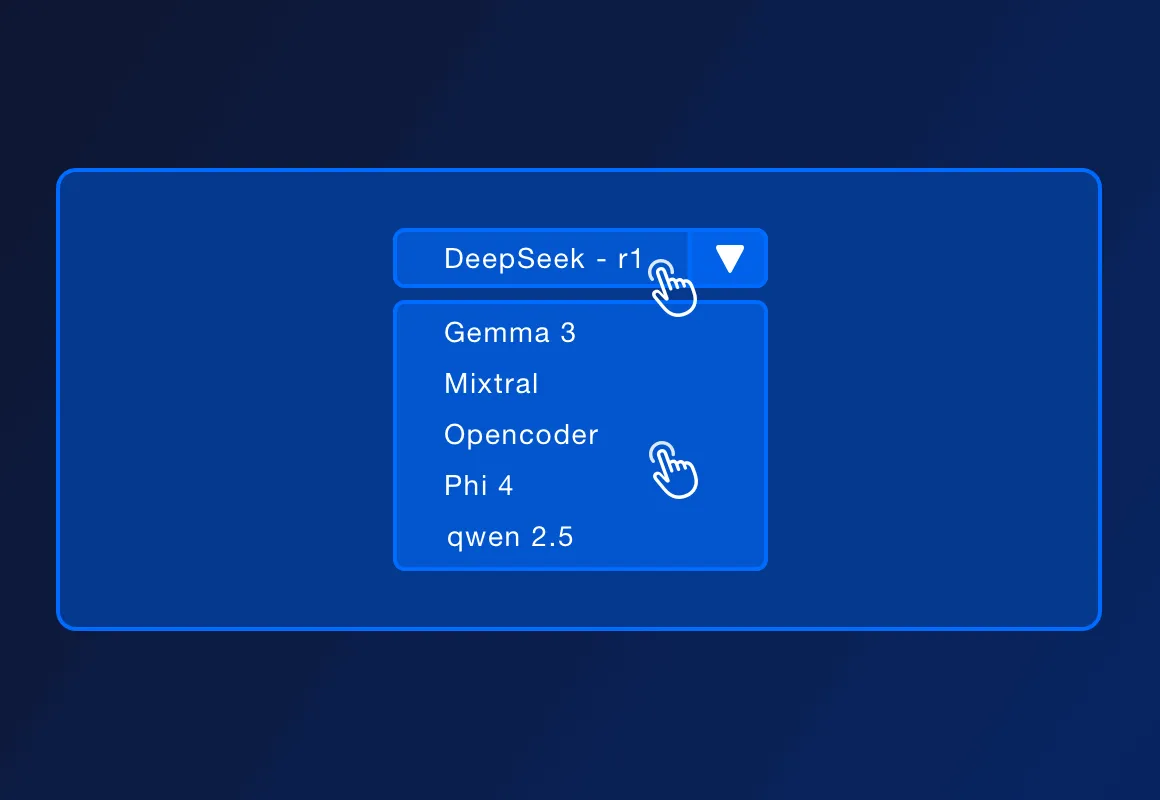

A ServBay suporta vários LLM populares e de código aberto, como DeepSeek - r1, Llama 3.3, Mistral, Code Llama, entre outros. A lista de modelos suportados pode aumentar com as atualizações oficiais.

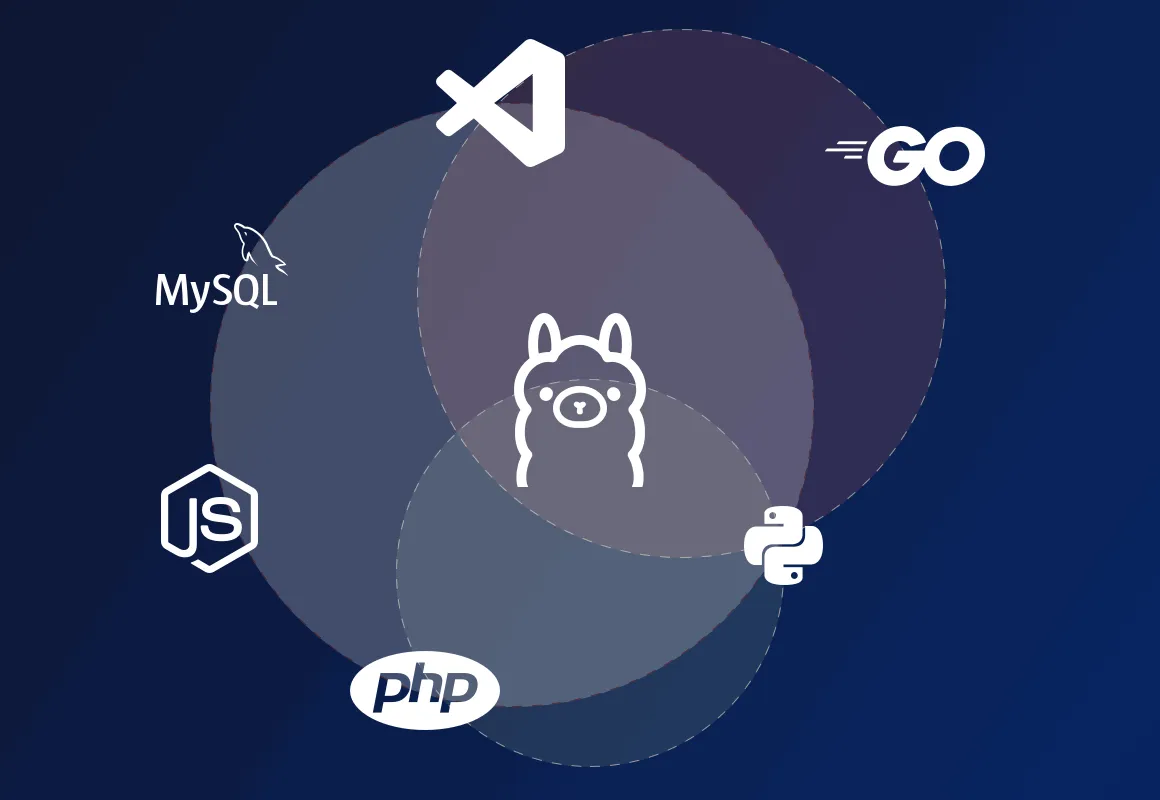

A ServBay suporta a implantação de ambientes de desenvolvimento local para PHP, Python, Node.js, Go, e, juntamente com o Ollama, é apropriada para desenvolvimento local, design de protótipos, aprendizado e uso pessoal. Em ambientes de produção que exigem alta concorrência, alta disponibilidade e funcionalidades de gerenciamento complexas, a ServBay pode oferecer soluções de implantação mais profissionais.

A ServBay é uma plataforma de gerenciamento de ambientes de desenvolvimento que oferece implantações de ambientes para linguagens como PHP, Python, Node.js e Go, além de fornecer suporte para vários bancos de dados e servidores. Agora, a ServBay ainda suporta a instalação com um clique do Ollama, permitindo que os desenvolvedores interajam com os modelos executados localmente por meio da API REST fornecida pelo Ollama, enviando entradas de texto e recebendo saídas do modelo, possibilitando a construção de diversas aplicações e serviços impulsionados por IA localmente.