Prise en main rapide, fin de la complexité

Les principaux avantages de ServBay résident dans l’installation en un clic du LLM, l’exécution locale, la confidentialité des données, l'utilisation hors ligne et des coûts réduits. Contrairement aux services LLM en cloud, ServBay ne nécessite pas de connexion réseau, les données restent locales, sans crainte de fuite de confidentialité.

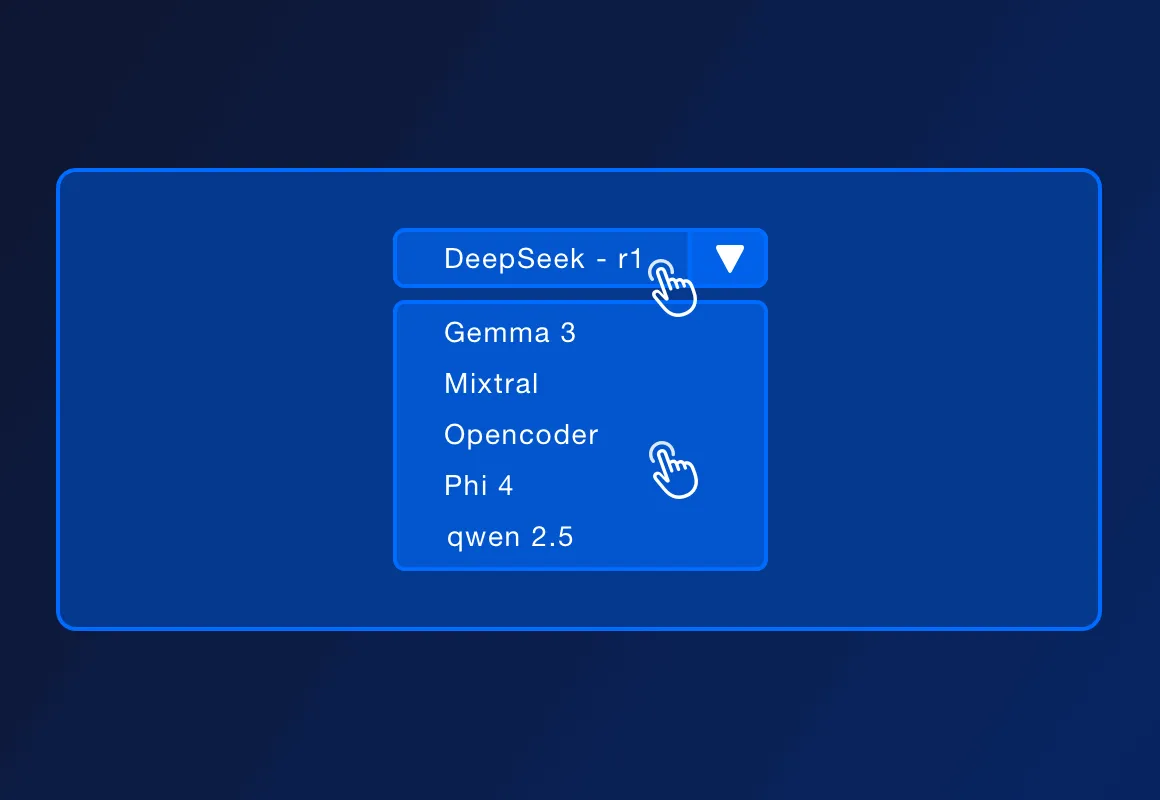

ServBay prend en charge plusieurs LLM open source populaires, tels que DeepSeek - r1, Llama 3.3, Mistral, Code Llama, etc. La liste des modèles pris en charge peut être augmentée avec les mises à jour officielles.

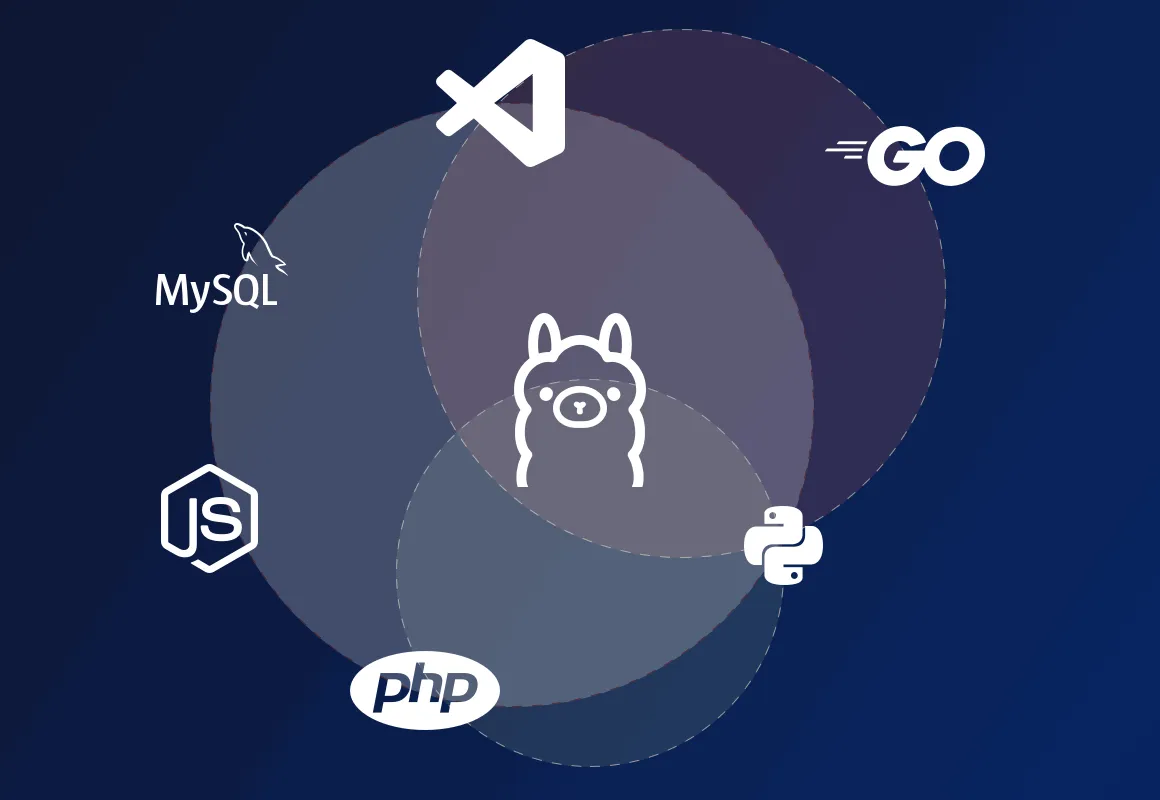

ServBay prend en charge le déploiement d’environnements de développement locaux en PHP, Python, Node.js, Go, s’associant à Ollama pour le développement local, la conception de prototypes, l’apprentissage et un usage personnel. Dans un environnement de production nécessitant une haute disponibilité, une gestion complexe et une forte charge de travail, ServBay peut également offrir des solutions de déploiement plus professionnelles.

ServBay est lui-même une plateforme de gestion d’environnement de développement, offrant le déploiement d’environnements de développement pour les langages PHP, Python, Node.js et Go, ainsi que divers support de bases de données et de serveurs. Aujourd'hui, ServBay prend également en charge l'installation en un clic d'Ollama, permettant aux développeurs d'interagir avec les modèles en cours d'exécution localement via l'API REST fournie par Ollama, en envoyant des entrées textuelles et en recevant des sorties de modèles, permettant ainsi de construire localement diverses applications et services alimentés par AI.